Die Geschichte der künstlichen Intelligenz mag sich für Menschen, die sich in der Informatik und ihren Teilbereichen nicht auskennen, wie ein dichtes und undurchdringliches Thema anfühlen.

Auch wenn künstliche Intelligenz rätselhaft und unantastbar erscheinen mag, so ist sie doch viel leichter zu verstehen, als man vielleicht denkt.

Was ist künstliche Intelligenz?

Künstliche Intelligenz ist ein Teilgebiet der Informatik, das sich mit maschineller Intelligenz (d.h. nicht-menschlicher Intelligenz) befasst.

Laienhaft ausgedrückt ist KI das Verständnis, dass Maschinen externe Daten so interpretieren, verarbeiten und daraus lernen können, dass sie kognitive Praktiken, die normalerweise dem Menschen zugeschrieben werden, funktionell imitieren. Künstliche Intelligenz basiert auf der Vorstellung, dass menschliche Denkprozesse sowohl repliziert als auch mechanisiert werden können.

Sprung zu:

KI von 380 v. Chr. bis 1900

KI von 1900-1950

KI in den 1950er Jahren

KI in den 1960er Jahren

KI in den 1970er Jahren

KI in den 1980er Jahren

KI in den 1990er Jahren

KI von 2000-2010

KI 2010 bis heute

Die Geschichte der künstlichen Intelligenz reicht bis in die Antike zurück, wo Philosophen über die Idee nachdachten, dass künstliche Wesen, mechanische Menschen und andere Automaten in irgendeiner Form existiert haben oder existieren könnten.

Dank der frühen Denker wurde künstliche Intelligenz um 1700 und danach immer greifbarer. Philosophen dachten darüber nach, wie menschliches Denken künstlich mechanisiert und von intelligenten nicht-menschlichen Maschinen manipuliert werden könnte. Die Denkprozesse, die das Interesse an künstlicher Intelligenz weckten, entstanden, als klassische Philosophen, Mathematiker und Logiker über die (mechanische) Manipulation von Symbolen nachdachten, was schließlich in den 1940er Jahren zur Erfindung eines programmierbaren Digitalcomputers, des Atanasoff Berry Computer (ABC), führte. Diese Erfindung inspirierte die Wissenschaftler zu der Idee, ein „elektronisches Gehirn“ oder ein künstlich intelligentes Wesen zu schaffen.

Es verging fast ein Jahrzehnt, bis die Ikonen der KI zum Verständnis des heutigen Bereichs beitrugen. Alan Turing, ein Mathematiker, schlug unter anderem einen Test vor, der die Fähigkeit einer Maschine, menschliche Handlungen bis zu einem Grad zu reproduzieren, der von menschlichem Verhalten nicht zu unterscheiden ist, messen sollte. Später in diesem Jahrzehnt wurde der Bereich der KI-Forschung auf einer Sommerkonferenz am Dartmouth College Mitte der 1950er Jahre begründet, auf der John McCarthy, Computer- und Kognitionswissenschaftler, den Begriff „künstliche Intelligenz“ prägte.

Ab den 1950er Jahren trugen viele Wissenschaftler, Programmierer, Logiker und Theoretiker dazu bei, das moderne Verständnis der künstlichen Intelligenz als Ganzes zu festigen. Mit jedem neuen Jahrzehnt kamen Innovationen und Erkenntnisse hinzu, die das grundlegende Wissen der Menschen über den Bereich der künstlichen Intelligenz veränderten, und wie historische Fortschritte die KI von einer unerreichbaren Fantasie zu einer greifbaren Realität für heutige und künftige Generationen katapultiert haben.

Lesen Sie weiter, um mehr über bestimmte Fortschritte und Momente in der Geschichte der KI zu erfahren.

Schlüsselereignisse in der Geschichte der künstlichen Intelligenz

Es ist nicht überraschend, dass sich die künstliche Intelligenz nach 1900 rasant entwickelt hat, aber überraschend ist, wie viele Menschen schon Hunderte von Jahren über KI nachgedacht haben, bevor es überhaupt ein Wort gab, um zu beschreiben, worüber sie nachdachten.

KI von 380 v. Chr. bis 1900

Zwischen 380 v. Chr. und den späten 1600er Jahren: Verschiedene Mathematiker, Theologen, Philosophen, Professoren und Schriftsteller dachten über mechanische Techniken, Rechenmaschinen und Zahlensysteme nach, die schließlich zum Konzept des mechanisierten „menschlichen“ Denkens in nicht-menschlichen Wesen führten.

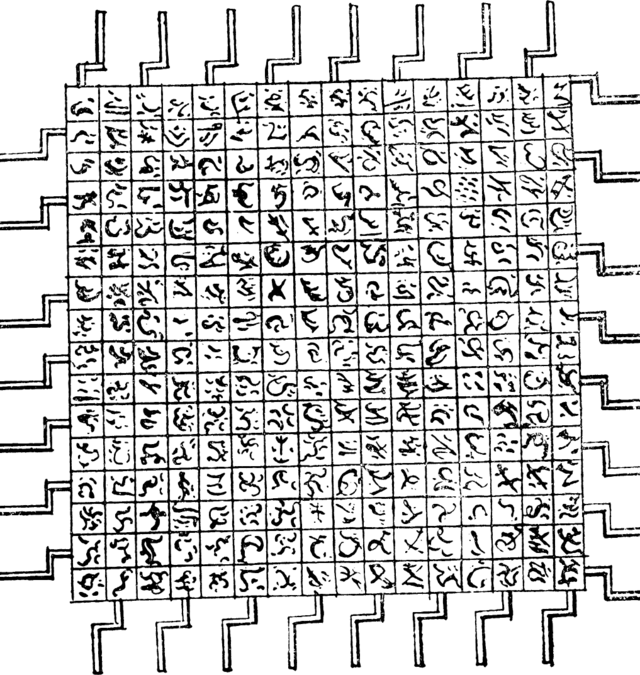

Frühes 17. Jahrhundert: Darstellungen von allwissenden, computerähnlichen Maschinen wurden in der Populärliteratur breiter diskutiert. In Jonathan Swifts Roman „Gullivers Reisen“ wird ein Gerät namens „Maschine“ erwähnt, eine der frühesten Erwähnungen moderner Technologie, insbesondere eines Computers. Der Zweck dieses Geräts bestand darin, das Wissen und die mechanischen Abläufe so weit zu verbessern, dass selbst die am wenigsten begabte Person geschickt zu sein schien – und das alles mit der Hilfe und dem Wissen eines nicht-menschlichen Geistes (der künstliche Intelligenz nachahmt).

1872: Der Autor Samuel Butler spielt in seinem Roman „Erewhon“ mit dem Gedanken, dass Maschinen zu einem unbestimmten Zeitpunkt in der Zukunft das Potenzial haben, ein Bewusstsein zu besitzen.

Künstliche Intelligenz von 1900-1950

Ab 1900 nahm das Tempo der Innovationen im Bereich der künstlichen Intelligenz deutlich zu.

1921: Karel Čapek, ein tschechischer Dramatiker, veröffentlichte sein Science-Fiction-Stück „Rossum’s Universal Robots“ (englische Übersetzung). Sein Stück befasste sich mit dem Konzept von fabrikmäßig hergestellten künstlichen Menschen, die er Roboter nannte – die erste bekannte Erwähnung des Wortes. Von diesem Zeitpunkt an griffen die Menschen die „Roboter“-Idee auf und setzten sie in ihre Forschung, Kunst und Entdeckungen um.

1927: Der Science-Fiction-Film Metropolis von Fritz Lang zeigt ein Robotermädchen, das von seinem menschlichen Gegenstück, dem es nachempfunden ist, körperlich nicht zu unterscheiden ist. Das künstlich intelligente Robotermädchen greift daraufhin die Stadt an und richtet im futuristischen Berlin großen Schaden an. Dieser Film ist von Bedeutung, weil er die erste Darstellung eines Roboters auf der Leinwand ist und somit Inspiration für andere berühmte nicht-menschliche Figuren wie C-P30 in Star Wars lieferte.

1929: Der japanische Biologe und Professor Makoto Nishimura entwickelt Gakutensoku, den ersten in Japan gebauten Roboter. Gakutensoku bedeutet übersetzt „Lernen aus den Gesetzen der Natur“, was bedeutet, dass der künstlich intelligente Verstand des Roboters Wissen von Menschen und der Natur ableiten konnte. Er konnte unter anderem seinen Kopf und seine Hände bewegen und seine Mimik verändern.

1939: John Vincent Atanasoff (Physiker und Erfinder) entwickelte zusammen mit seinem studentischen Assistenten Clifford Berry den Atanasoff-Berry-Computer (ABC) mit einem Zuschuss von 650 Dollar an der Iowa State University. Der ABC wog über 700 Pfund und konnte bis zu 29 simultane lineare Gleichungen lösen.

1949: Der Computerwissenschaftler Edmund Berkeley schreibt in seinem Buch „Giant Brains: Or Machines That Think“ stellt fest, dass Maschinen zunehmend in der Lage sind, große Mengen an Informationen schnell und geschickt zu verarbeiten. Er verglich Maschinen mit einem menschlichen Gehirn, wenn es aus „Hardware und Draht statt aus Fleisch und Nerven“ bestünde, und beschrieb die Fähigkeiten von Maschinen mit denen des menschlichen Geistes: „Eine Maschine kann also denken.“

Künstliche Intelligenz in den 1950er Jahren

Die 1950er Jahre erwiesen sich als eine Zeit, in der viele Fortschritte auf dem Gebiet der künstlichen Intelligenz mit einem Aufschwung forschungsbasierter Erkenntnisse auf dem Gebiet der künstlichen Intelligenz, u. a. von verschiedenen Informatikern, zum Tragen kamen.

1950: Claude Shannon, „der Vater der Informationstheorie“, veröffentlicht „Programming a Computer for Playing Chess“, den ersten Artikel, der die Entwicklung eines schachspielenden Computerprogramms beschreibt.

1950: Alan Turing veröffentlicht „Computing Machinery and Intelligence“, in dem er die Idee des „Imitation Game“ vorschlägt – eine Frage, die untersucht, ob Maschinen denken können. Aus diesem Vorschlag wurde später der Turing-Test, mit dem die (künstliche) Intelligenz von Maschinen gemessen wurde. Mit Turings Entwicklung wurde die Fähigkeit einer Maschine getestet, wie ein Mensch zu denken. Der Turing-Test wurde zu einem wichtigen Bestandteil der Philosophie der künstlichen Intelligenz, in der Intelligenz, Bewusstsein und Fähigkeiten von Maschinen diskutiert werden.

1952: Arthur Samuel, ein Informatiker, entwickelt ein Schach spielendes Computerprogramm – das erste, das selbstständig lernt, wie man ein Spiel spielt.

1955: John McCarthy und ein Team von Männern erstellen einen Vorschlag für einen Workshop über „künstliche Intelligenz“. Als der Workshop 1956 stattfand, wurde die offizielle Geburt des Wortes McCarthy zugeschrieben.

1955: Allen Newell (Forscher), Herbert Simon (Wirtschaftswissenschaftler) und Cliff Shaw (Programmierer) schreiben gemeinsam an Logic Theorist, dem ersten Computerprogramm für künstliche Intelligenz.

1958: McCarthy entwickelte Lisp, die beliebteste und immer noch bevorzugte Programmiersprache für die Forschung im Bereich der künstlichen Intelligenz.

1959: Samuel prägte den Begriff „maschinelles Lernen“, als er davon sprach, einen Computer so zu programmieren, dass er eine Schachpartie besser spielt als der Mensch, der das Programm geschrieben hat.

Künstliche Intelligenz in den 1960er Jahren

Innovationen auf dem Gebiet der künstlichen Intelligenz nahmen in den 1960er Jahren rasch zu. Die Entwicklung neuer Programmiersprachen, Roboter und Automaten, Forschungsstudien und Filme, die künstlich intelligente Wesen darstellten, wurden immer beliebter. Dadurch wurde die Bedeutung der KI in der zweiten Hälfte des 20. Jahrhunderts stark hervorgehoben.

1961: Unimate, ein von George Devol in den 1950er Jahren erfundener Industrieroboter, wurde als erster an einem Fließband von General Motors in New Jersey eingesetzt. Zu seinen Aufgaben gehören der Transport von Druckgussteilen vom Fließband und das Anschweißen der Teile an Autos – eine Aufgabe, die für Menschen als gefährlich gilt.

1961: James Slagle, Informatiker und Professor, entwickelt SAINT (Symbolic Automatic INTegrator), ein heuristisches Problemlösungsprogramm, dessen Schwerpunkt auf der symbolischen Integration in der Studienanfängerrechnung liegt.

1964: Daniel Bobrow, Informatiker, entwickelt STUDENT, ein frühes KI-Programm, das in Lisp geschrieben ist und Wortprobleme der Algebra löst. STUDENT wird als ein früher Meilenstein der KI-Verarbeitung natürlicher Sprache bezeichnet.

1965: Joseph Weizenbaum, Informatiker und Professor, entwickelt ELIZA, ein interaktives Computerprogramm, das sich mit einem Menschen auf Englisch unterhalten kann. Weizenbaums Ziel war es, zu demonstrieren, dass die Kommunikation zwischen einem künstlich intelligenten Geist und einem menschlichen Geist „oberflächlich“ ist, aber er entdeckte, dass viele Menschen ELIZA anthropomorphe Eigenschaften zuschrieben.

1966: Shakey the Robot, entwickelt von Charles Rosen mit der Hilfe von 11 anderen, war der erste mobile Universalroboter, auch bekannt als der „erste elektronische Mensch“

1968: Der Science-Fiction-Film 2001: Odyssee im Weltraum unter der Regie von Stanley Kubrick wird veröffentlicht. Er zeigt HAL (Heuristically programmed ALgorithmic computer), einen intelligenten Computer. HAL steuert die Systeme des Raumschiffs und interagiert mit der Schiffsbesatzung, indem er sich mit ihnen unterhält, als wäre HAL ein Mensch, bis eine Fehlfunktion die Interaktionen von HAL negativ verändert.

1968: Terry Winograd, Professor für Informatik, schuf SHRDLU, ein frühes Computerprogramm für natürliche Sprache.

Künstliche Intelligenz in den 1970er Jahren

Wie in den 1960er Jahren gab es auch in den 1970er Jahren beschleunigte Fortschritte, insbesondere bei Robotern und Automaten. Allerdings stand die künstliche Intelligenz in den 1970er Jahren vor Herausforderungen, wie z. B. der reduzierten staatlichen Unterstützung für die KI-Forschung.

1970: WABOT-1, der erste anthropomorphe Roboter, wurde in Japan an der Waseda-Universität gebaut. Zu seinen Merkmalen gehören bewegliche Gliedmaßen, die Fähigkeit zu sehen und sich zu unterhalten.

1973: James Lighthill, angewandter Mathematiker, berichtet dem britischen Wissenschaftsrat über den Stand der Forschung im Bereich der künstlichen Intelligenz und stellt fest: „In keinem Teil des Feldes haben die bisherigen Entdeckungen die damals versprochenen großen Auswirkungen gehabt“, was zu einer deutlich reduzierten Unterstützung der KI-Forschung durch die britische Regierung führte.

1977: Der Film Star Wars von Regisseur George Lucas kommt in die Kinos. Der Film zeigt C-3PO, einen humanoiden Roboter, der als Protokolldroide konzipiert ist und „mehr als sieben Millionen Kommunikationsformen fließend beherrscht.“ Als Begleiter von C-3PO tritt im Film auch R2-D2 auf – ein kleiner Astromech-Droide, der nicht in der Lage ist, menschlich zu sprechen (das Gegenteil von C-3PO); stattdessen kommuniziert R2-D2 mit elektronischen Pieptönen. Zu seinen Aufgaben gehören kleine Reparaturen und das Steuern von Raumjägern.

1979: Der Stanford Cart, ein ferngesteuerter, mit einem Fernseher ausgestatteter mobiler Roboter, wurde 1961 vom damaligen Maschinenbaustudenten James L. Adams entwickelt. 1979 fügte der damalige Doktorand Hans Moravec einen „Slider“, ein mechanisches Drehgelenk, hinzu, mit dem die Fernsehkamera von einer Seite zur anderen bewegt werden konnte. Der Wagen durchquerte erfolgreich einen mit Stühlen gefüllten Raum ohne menschliches Zutun in etwa fünf Stunden und war damit eines der ersten Beispiele für ein autonomes Fahrzeug.

AI in den 1980er Jahren

Das rasante Wachstum der künstlichen Intelligenz setzte sich in den 1980er Jahren fort. Trotz der Fortschritte und der Begeisterung für die KI wurde ein unvermeidlicher „KI-Winter“ befürchtet, eine Zeit, in der die Finanzierung und das Interesse an künstlicher Intelligenz zurückgingen.

1980: WABOT-2 wurde an der Waseda Universität gebaut. Diese erste Version des WABOT ermöglicht es dem Humanoiden, mit Menschen zu kommunizieren, Partituren zu lesen und Musik auf einer elektronischen Orgel zu spielen.

1981: Das japanische Ministerium für internationalen Handel und Industrie stellt 850 Millionen Dollar für das Fifth Generation Computer Projekt zur Verfügung, dessen Ziel es ist, Computer zu entwickeln, die sich unterhalten, Sprachen übersetzen, Bilder interpretieren und menschenähnliche Gedankengänge ausdrücken können.

1984: Der Film Electric Dreams unter der Regie von Steve Barron wird veröffentlicht. Die Handlung dreht sich um eine Dreiecksbeziehung zwischen einem Mann, einer Frau und einem empfindungsfähigen Personal Computer namens „Edgar“.

1984: Auf der Association for the Advancement of Artificial Intelligence (AAAI) warnen Roger Schank (KI-Theoretiker) und Marvin Minsky (Kognitionswissenschaftler) vor dem KI-Winter, dem ersten Fall, in dem das Interesse und die Finanzierung der Forschung im Bereich der künstlichen Intelligenz zurückgehen würden. Ihre Warnung wurde innerhalb von drei Jahren wahr.

1986: Mercedes-Benz baute und veröffentlichte unter der Leitung von Ernst Dickmanns einen fahrerlosen Transporter, der mit Kameras und Sensoren ausgestattet war. Er war in der Lage, auf einer Straße ohne andere Hindernisse oder menschliche Fahrer bis zu 55 km/h zu fahren.

1988: Der Informatiker und Philosoph Judea Pearl veröffentlicht „Probabilistic Reasoning in Intelligent Systems“. Pearl gilt auch als Erfinder der Bayes’schen Netze, eines „probabilistischen grafischen Modells“, das Variablensätze und ihre Abhängigkeiten durch gerichtete azyklische Graphen (DAG) darstellt.

1988: Rollo Carpenter, Programmierer und Erfinder von zwei Chatbots, Jabberwacky und Cleverbot (veröffentlicht in den 1990er Jahren), entwickelte Jabberwacky, um „den natürlichen menschlichen Chat auf interessante, unterhaltsame und humorvolle Weise zu simulieren.“ Dies ist ein Beispiel für KI über einen Chatbot, der mit Menschen kommuniziert.

KI in den 1990er Jahren

Das Ende des Jahrtausends war in Sicht, aber diese Vorahnung half der künstlichen Intelligenz nur in ihren weiteren Wachstumsstufen.

1995: Der Informatiker Richard Wallace entwickelte den Chatbot A.L.I.C.E (Artificial Linguistic Internet Computer Entity), inspiriert von Weizenbaums ELIZA. Was A.L.I.C.E. von ELIZA unterscheidet, ist die zusätzliche Sammlung von natürlichsprachlichen Musterdaten.

1997: Die Informatiker Sepp Hochreiter und Jürgen Schmidhuber entwickelten das Long Short-Term Memory (LSTM), eine Art rekurrentes neuronales Netz (RNN), das für die Handschrift- und Spracherkennung verwendet wird.

1997: Deep Blue, ein von IBM entwickelter Schachcomputer, ist das erste System, das eine Schachpartie und ein Match gegen einen amtierenden Weltmeister gewinnt.

1998: Dave Hampton und Caleb Chung erfanden Furby, den ersten „Haustier“-Spielzeugroboter für Kinder.

1999: In Anlehnung an Furby brachte Sony AIBO (Artificial Intelligence RoBOt) auf den Markt, einen 2.000 Dollar teuren Roboterhund, der durch Interaktion mit seiner Umgebung, seinen Besitzern und anderen AIBOs „lernen“ konnte. Zu seinen Funktionen gehörte die Fähigkeit, mehr als 100 Sprachbefehle zu verstehen und darauf zu reagieren und mit seinem menschlichen Besitzer zu kommunizieren.

KI von 2000-2010

Das neue Jahrtausend war angebrochen – und nachdem die Ängste vor dem Jahr 2000 nachgelassen hatten, setzte sich der Aufwärtstrend der KI fort. Wie erwartet, wurden mehr künstlich intelligente Wesen geschaffen und kreative Medien (insbesondere Filme) über das Konzept der künstlichen Intelligenz und ihre mögliche Entwicklung entwickelt.

2000: Das Jahr-2000-Problem, auch als Jahr-2000-Problem bekannt, war eine Klasse von Computerfehlern im Zusammenhang mit der Formatierung und Speicherung von elektronischen Kalenderdaten ab dem 01.01.2000. Da alle Internet-Software und -Programme in den 1900er Jahren entwickelt worden waren, hatten einige Systeme Schwierigkeiten, sich an das neue Jahresformat des Jahres 2000 (und darüber hinaus) anzupassen. Bisher mussten diese automatisierten Systeme nur die letzten beiden Ziffern der Jahreszahl ändern; jetzt mussten alle vier Ziffern umgestellt werden – eine Herausforderung für die Technik und ihre Benutzer.

2000: Professor Cynthia Breazeal entwickelte Kismet, einen Roboter, der mit seinem Gesicht Emotionen erkennen und simulieren konnte. Es war wie ein menschliches Gesicht aufgebaut, mit Augen, Lippen, Augenlidern und Augenbrauen.

2000: Honda bringt ASIMO heraus, einen künstlich intelligenten humanoiden Roboter.

2001: Der Science-Fiction-Film A.I. Artificial Intelligence unter der Regie von Steven Spielberg wird veröffentlicht. Der Film spielt in einer futuristischen, dystopischen Gesellschaft und folgt David, einem fortschrittlichen humanoiden Kind, das mit anthropomorphen Gefühlen programmiert wurde, einschließlich der Fähigkeit zu lieben.

2002: i-Robot bringt Roomba heraus, einen autonomen Staubsaugerroboter, der reinigt und dabei Hindernissen ausweicht.

2004: Die NASA-Roboter Spirit und Opportunity navigieren ohne menschliches Zutun auf der Marsoberfläche.

2004: Der Science-Fiction-Film I, Robot unter der Regie von Alex Proyas wird veröffentlicht. Er spielt im Jahr 2035, wo humanoide Roboter der Menschheit dienen, während eine Person angesichts des Ausgangs einer persönlichen Tragödie (die von einem Roboter bestimmt wurde) vehement gegen Roboter ist.

2006: Oren Etzioni (Informatikprofessor), Michele Banko und Michael Cafarella (Informatiker) prägen den Begriff „maschinelles Lesen“ und definieren ihn als unbeaufsichtigtes autonomes Verstehen von Text.

2007: Der Informatikprofessor Fei Fei Li und seine Kollegen stellen ImageNet zusammen, eine Datenbank mit kommentierten Bildern, die bei der Erforschung von Objekterkennungssoftware helfen soll.

2009: Google entwickelt heimlich ein fahrerloses Auto. Im Jahr 2014 bestand es den Selbstfahrertest in Nevada.

KI 2010 bis heute

Das aktuelle Jahrzehnt war für die KI-Innovation von enormer Bedeutung. Seit 2010 ist die künstliche Intelligenz in unseren Alltag eingebettet worden. Wir benutzen Smartphones mit Sprachassistenten und Computer mit „intelligenten“ Funktionen, die für die meisten von uns selbstverständlich sind. KI ist kein Hirngespinst mehr und war es auch schon lange nicht mehr.

2010: ImageNet startet die ImageNet Large Scale Visual Recognition Challenge (ILSVRC), ihren jährlichen Wettbewerb zur KI-Objekterkennung.

2010: Microsoft bringt Kinect für die Xbox 360 auf den Markt, das erste Spielgerät, das die Bewegungen des menschlichen Körpers mithilfe einer 3D-Kamera und Infrarot-Erkennung erfasst.

2011: Watson, ein von IBM entwickelter Computer, der Fragen in natürlicher Sprache beantwortet, besiegt zwei ehemalige Jeopardy! Champions, Ken Jennings und Brad Rutter, in einem im Fernsehen übertragenen Spiel.

2011: Apple veröffentlicht Siri, einen virtuellen Assistenten für das Apple-Betriebssystem iOS. Siri verwendet eine natürlichsprachliche Benutzeroberfläche, um seinem menschlichen Benutzer Dinge zu erklären, zu beobachten, zu beantworten und zu empfehlen. Sie passt sich an Sprachbefehle an und projiziert eine „individualisierte Erfahrung“ pro Benutzer.

2012: Jeff Dean und Andrew Ng (Google-Forscher) trainierten ein großes neuronales Netzwerk aus 16.000 Prozessoren darauf, Bilder von Katzen zu erkennen (obwohl sie keine Hintergrundinformationen lieferten), indem sie ihm 10 Millionen unbeschriftete Bilder aus YouTube-Videos zeigten.

2013: Ein Forscherteam der Carnegie Mellon University veröffentlicht den Never Ending Image Learner (NEIL), ein semantisches maschinelles Lernsystem, das Bildbeziehungen vergleichen und analysieren kann.

2014: Microsoft veröffentlicht Cortana, seine Version eines virtuellen Assistenten, ähnlich wie Siri auf iOS.

2014: Amazon entwickelt Amazon Alexa, einen Heimassistenten, der sich zu intelligenten Lautsprechern entwickelt, die als persönliche Assistenten fungieren.

Verwandt: Sehen Sie sich die 43 Statistiken zur Sprachsuche an, um zu sehen, wie beliebt diese Technologie wirklich ist.

![]()

2015: Elon Musk, Stephen Hawking und Steve Wozniak unter 3.000 anderen unterzeichnen einen offenen Brief, der die Entwicklung und den Einsatz von autonomen Waffen (zu Kriegszwecken) verbietet.

2015-2017: AlphaGo von Google DeepMind, ein Computerprogramm, das das Brettspiel Go spielt, besiegte mehrere (menschliche) Champions.

2016: Ein humanoider Roboter namens Sophia wird von Hanson Robotics entwickelt. Sie wird als erste „Roboterbürgerin“ bezeichnet. Was Sophia von früheren Humanoiden unterscheidet, ist ihre Ähnlichkeit mit einem echten Menschen, mit ihrer Fähigkeit zu sehen (Bilderkennung), Mimik zu machen und durch KI zu kommunizieren.

2016: Google bringt Google Home auf den Markt, einen intelligenten Lautsprecher, der mithilfe von KI als „persönlicher Assistent“ fungiert und den Nutzern hilft, sich an Aufgaben zu erinnern, Termine zu vereinbaren und per Sprache nach Informationen zu suchen.

2017: Das Facebook-Forschungslabor für künstliche Intelligenz trainierte zwei „Dialogagenten“ (Chatbots), miteinander zu kommunizieren, um zu lernen, wie man verhandelt. Während die Chatbots sich unterhielten, wichen sie jedoch von der menschlichen Sprache (die auf Englisch programmiert war) ab und erfanden ihre eigene Sprache, um miteinander zu kommunizieren – ein Beweis für ein hohes Maß an künstlicher Intelligenz.

2018: Die sprachverarbeitende KI von Alibaba (chinesischer Technologiekonzern) übertraf den menschlichen Intellekt bei einem Lese- und Verständnistest in Stanford. Die Alibaba-Sprachverarbeitung erzielte „82,44 gegenüber 82,30 bei einem Satz von 100.000 Fragen“ – eine knappe Niederlage, aber dennoch eine Niederlage.

2018: Google entwickelt BERT, die erste „bidirektionale, unüberwachte Sprachrepräsentation, die für eine Vielzahl von natürlichsprachlichen Aufgaben unter Verwendung von Transferlernen verwendet werden kann.“

2018: Samsung stellt Bixby vor, einen virtuellen Assistenten. Zu den Funktionen von Bixby gehören Voice (Sprache), mit der der Nutzer Fragen, Empfehlungen und Vorschläge stellen kann, Vision (Sehen), wobei Bixbys „Seh“-Fähigkeit in die Kamera-App integriert ist und sehen kann, was der Nutzer sieht (d. h.. Objektidentifikation, Suche, Kauf, Übersetzung, Landmarkenerkennung); und Home, wo Bixby App-basierte Informationen nutzt, um den Nutzer zu unterstützen und mit ihm zu interagieren (z. B. Wetter- und Fitnessanwendungen).

Was können wir 2019 und darüber hinaus von der KI erwarten?

Künstliche Intelligenz entwickelt sich in einem noch nie dagewesenen Tempo weiter. Wir können also davon ausgehen, dass sich die Trends des letzten Jahrzehnts auch im kommenden Jahr fortsetzen werden. Ein paar Dinge, auf die wir 2019 ein Auge haben sollten, sind:

- Chatbots + virtuelle Assistenten: Verstärkte Chatbot- und virtuelle Assistenten-Automatisierung für ein verbessertes Nutzererlebnis

- Natürliche Sprachverarbeitung (NLP): Verbesserte NLP-Fähigkeiten für künstlich intelligente Anwendungen, einschließlich (und insbesondere für) Chatbots und virtuelle Assistenten

- Maschinelles Lernen und automatisiertes maschinelles Lernen: ML wird sich in Richtung AutoML-Algorithmen verlagern, um es Entwicklern und Programmierern zu ermöglichen, Probleme zu lösen, ohne spezielle Modelle zu erstellen

- Autonome Fahrzeuge: Trotz der schlechten Presse im Zusammenhang mit verschiedenen fehlerhaften selbstfahrenden Fahrzeugen kann man davon ausgehen, dass es einen stärkeren Druck geben wird, den Prozess des Transports von Produkten von Punkt A nach Punkt B zu automatisieren, um 1. die Kosten für menschliche Arbeitskraft zu sparen und 2. den Prozess des Kaufs, der Lieferung und der Ankunft beim Verbraucher durch selbstfahrende Fahrzeuge zu optimieren, die – im Wesentlichen – nicht müde werden, hinter dem Steuer zu sitzen

Verwandt: Sehen Sie sich die neuesten Statistiken zur künstlichen Intelligenz für 2019 an, um über die neuesten KI-Technologien auf dem Laufenden zu bleiben.

![]()

Unser Ziel? Mit den Fortschritten in der KI Schritt zu halten

Um mit der Welt der Technik Schritt zu halten, müssen wir mit den Innovationen in der künstlichen Intelligenz Schritt halten. Von humanoiden Robotern wie Sophia bis hin zu Sprachassistenten wie Alexa – die KI entwickelt sich rasant weiter. Eines Tages werden die Menschen künstlich intelligente Begleiter haben, die über Spielzeuge wie AIBO oder Furby hinausgehen; eines Tages könnten KI und Menschheit auf eine Art und Weise koexistieren, bei der Menschen und Humanoide nicht mehr voneinander zu unterscheiden sind.

Und eines Tages?

Einst könnte es früher sein, als wir denken.

Sind Sie immer noch neugierig auf alles rund um KI? Informieren Sie sich über die Trends des Jahres 2019 im Bereich der künstlichen Intelligenz oder erfahren Sie mehr über die verschiedenen Arten von KI, um 2019 und darüber hinaus mehr Wissen zu erlangen!